Искусственный интеллект обретает здравомыслие. Источник: ИИ-генерация

Команда исследователей из МИСиС и МФТИ с коллегами разработала новый метод, который значительно повышает надежность нейронных сетей, обучая их эффективно распознавать объекты и ситуации, с которыми они не сталкивались в процессе обучения.

Предложенный подход, названный Identity Curvature Laplace Approximation (ICLA), позволяет искусственному интеллекту более точно оценивать собственную неуверенность, что является критически важным шагом для создания безопасных систем в таких областях, как беспилотный транспорт, медицинская диагностика и финансовый мониторинг.

Результаты работы были представлены на престижной Зимней конференции по применению компьютерного зрения (WACV 2025) в США и опубликованы в ее официальных трудах издательством IEEE.

Современные глубокие нейронные сети демонстрируют поразительные способности в распознавании образов, обработке языка и прогнозировании. Однако у них есть опасная особенность — излишняя самоуверенность.

Нейросеть, обученная различать кошек и собак, может с высокой степенью уверенности заявить, что изображение жирафа — это собака. В развлекательном приложении такая ошибка безобидна, но в системе автопилота, которая столкнулась с неизвестным препятствием на дороге, подобная «слепая» уверенность может привести к катастрофе.

Способность системы распознавать, что входные данные выходят за рамки ее «компетенции», называется детектированием вне распределенных данных (out-of-distribution, OOD). Это одна из самых актуальных проблем в области безопасности ИИ.

Одним из классических подходов к оценке неопределенности в ИИ являются байесовские методы. Их можно сравнить с созданием не одной, а целого ансамбля из тысяч возможных моделей, что позволяет оценить разброс их предсказаний. Однако такой подход требует огромных вычислительных ресурсов.

Более практичной альтернативой является аппроксимация Лапласа — метод, который пытается оценить неопределенность, анализируя «ландшафт» параметров модели в окрестности наилучшего найденного решения.

Этот ландшафт можно представить как горную местность, где самая высокая точка — это оптимальная модель. Форма этой вершины, ее кривизна, говорит о том, насколько модель уверена в своих параметрах. Острая, узкая вершина традиционно интерпретируется как высокая уверенность, а пологая и широкая — как низкая. Стандартные методы пытаются измерить эту сложную кривизну с помощью математического объекта, известного как матрица Гессе.

Российские исследователи поставили под сомнение фундаментальное предположение о том, что точное измерение этой кривизны всегда полезно для детектирования аномалий.

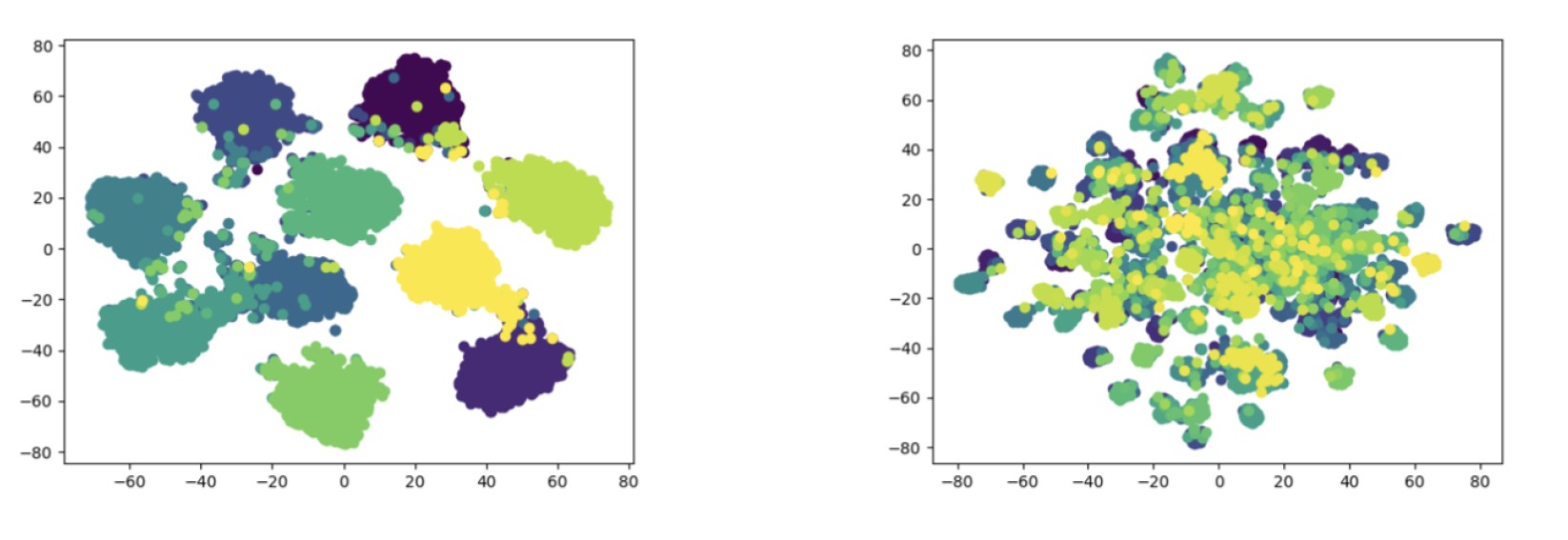

Рисунок 1. Визуализация того, как нейросеть «видит» данные из разных наборов. Каждая точка — это отдельное изображение, а цвета соответствуют разным классам. В датасете CIFAR-10 (слева) классы образуют четкие, хорошо разделенные кластеры. Именно в таких, казалось бы, простых случаях стандартные методы оценки неопределенности дают сбой. В более сложном датасете CIFAR-100 (справа) кластеры сильно пересекаются. Метод ICLA эффективен именно для задач с высокой разделимостью классов. Источник: WACV 2025

Они обнаружили парадокс: на задачах, где классы данных очень легко различимы (например, грузовики и самолеты), ландшафт решений нейросети становится чрезвычайно «острым». Стандартная аппроксимация Лапласа интерпретирует это как очень высокую уверенность, из-за чего модель теряет способность распознавать что-либо новое. Кривизна, которая должна была помочь оценить неопределенность, становится источником проблемы.

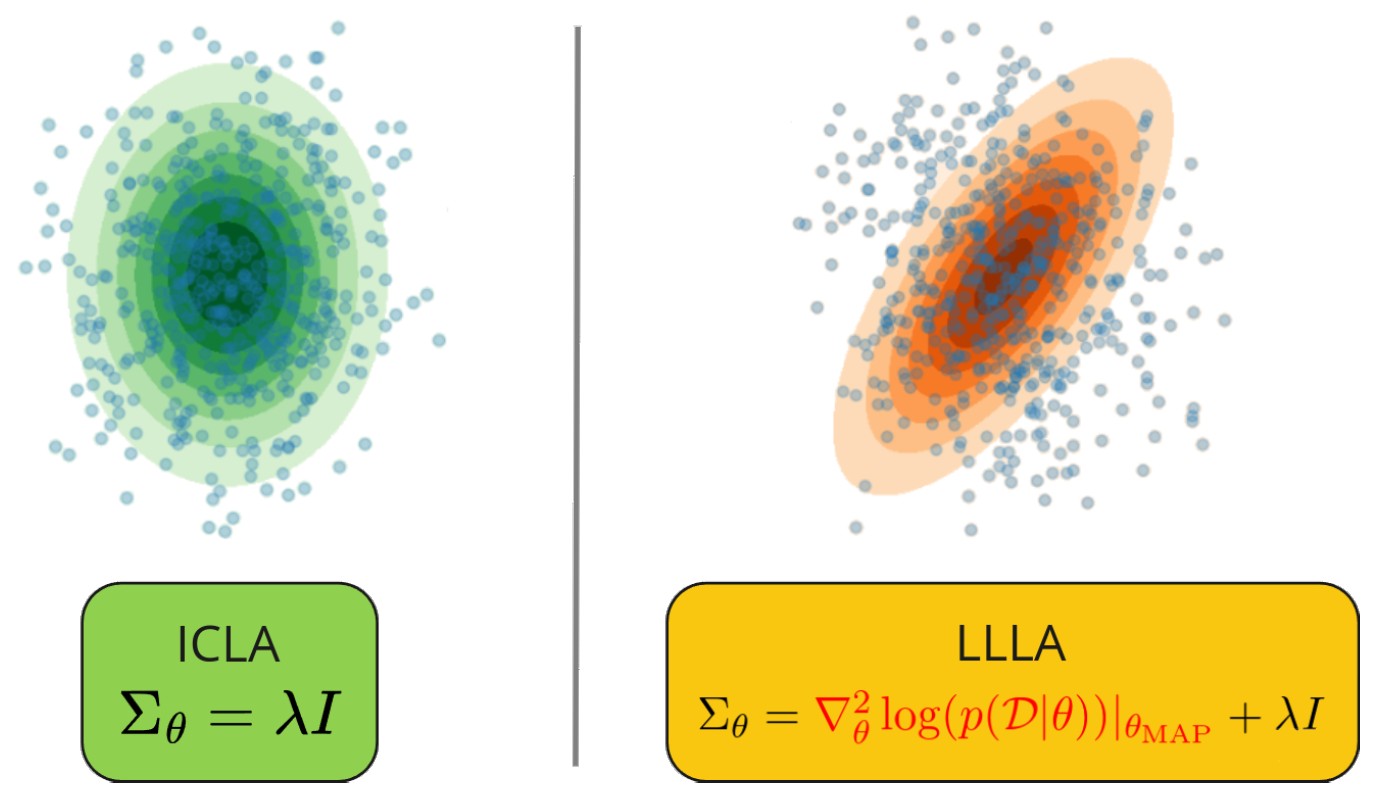

Рисунок 2. Схематичное изображение «ландшафтов неопределенности» для стандартного подхода (справа) и нового метода (слева). Стандартный метод, пытаясь точно описать сложную «кривизну» решений, создает узкую и изрезанную область уверенности, что приводит к ошибкам. Метод ICLA формирует более гладкий и широкий ландшафт, позволяя нейросети эффективнее распознавать аномалии, находящиеся за пределами ее «знаний». Источник: WACV 2025

Исследователи столкнулись с ситуацией, в которой чем лучше модель разделяла известные ей классы, тем хуже она справлялась с неизвестностью. Стандартный подход, основанный на измерении кривизны, давал сбой. Они предположили, что эта сложная информация о геометрии решений не только не помогает, но и мешает.

Поэтому ученые решили пойти на радикальное упрощение: вместо того чтобы вычислять сложную форму ландшафта, заменили ее на самую простую из возможных — идеальную, симметричную сферу, описываемую единичной матрицей.

Ключевым нововведением стало то, что исследователи не просто зафиксировали эту простую форму, а разработали алгоритм, который оптимизирует ее масштаб (параметр «априорной точности»), подстраивая его под конкретную задачу. В результате получился элегантный и вычислительно очень эффективный подход.

Тестирование на стандартных наборах данных для компьютерного зрения, таких как CIFAR-10, CIFAR-100 и ImageNet, показало, что ICLA значительно превосходит традиционную аппроксимацию Лапласа и другие популярные методы в задаче обнаружения вне распределенных данных. При этом он не снижает точность распознавания знакомых объектов и сохраняет калибровку модели — ее предсказания остаются честными.

Инновационность работы заключается в ее контринтуитивном выводе: для повышения надежности ИИ в условиях неопределенности нужно не усложнять, а упрощать модель его «сомнений». Ученые показали, что в некоторых случаях избыточная информация о геометрии пространства решений вредна. Отказ от нее и переход к более общей и гладкой оценке неопределенности позволяет нейросети лучше очертить границы известного и вовремя сигнализировать о столкновении с чем-то новым.

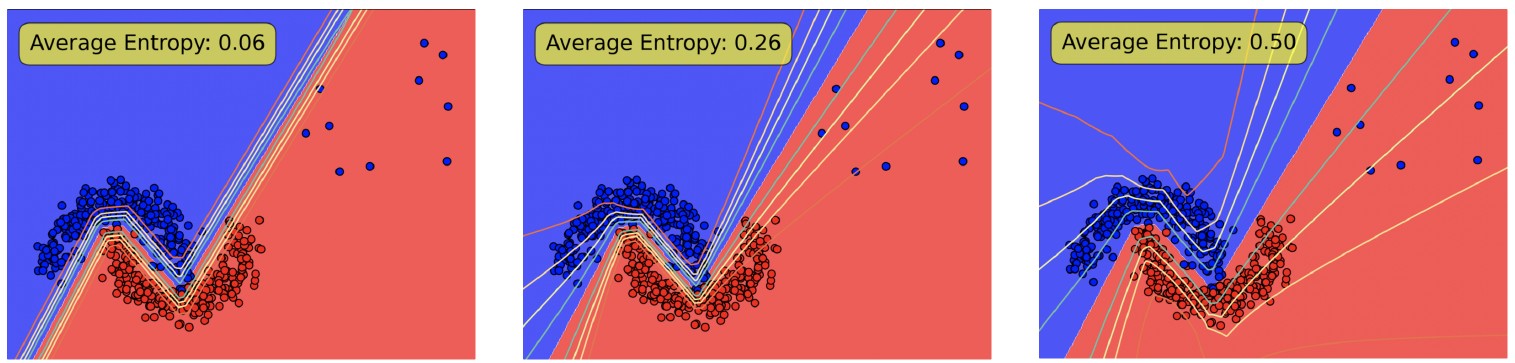

Рисунок 3. Работа разных методов на тестовой задаче. Синие и оранжевые точки — данные двух известных классов, красные — новые, неизвестные объекты (аномалии). Размытая переходная зона показывает неуверенность модели. Видно, как у метода ICLA (справа) зона неуверенности значительно шире, чем у стандартных подходов (в центре и слева), и она корректно охватывает аномальные данные, присваивая им наивысший уровень неопределенности (Average Entropy: 0.50). Источник: WACV 2025

Станислав Дерека, аспирант МФТИ, добавил: «Наш метод не только эффективен, но и практически выгоден. Он почти не требует дополнительных вычислений на этапе использования модели, что делает его легко применимым в реальных системах, где важна скорость реакции. По сути, мы предлагаем простой „апгрейд” для уже существующих нейросетей, который делает их значительно безопаснее. Это открывает путь к созданию более надежных систем ИИ для беспилотных автомобилей, которые смогут лучше реагировать на нестандартные дорожные ситуации, или для медицинских систем, способных вовремя обратить внимание врача на редкий или атипичный случай».

Это исследование вносит важный вклад как в практическое применение ИИ, так и в фундаментальную науку. Оно углубляет понимание того, как нейронные сети работают с неопределенностью, и указывает на ограничения существующих методов.