Нобелевскую премию по физике за 2024 год поделили американец Джон Хопфилд (John Hopfield), изобретатель модели ассоциативной памяти, с разработчиком алгоритмов «глубокого обучения» Джеффри Хинтоном (Jeoffrey Hinton).

Нобелевскую премию по физике за 2024 год поделили американец Джон Хопфилд (John Hopfield), изобретатель модели ассоциативной памяти, с разработчиком алгоритмов «глубокого обучения» Джеффри Хинтоном (Jeoffrey Hinton).

Генеалогия идеи «умной» искусственной системы уходит в далёкое прошлое — если сильно увлечься, то можно добраться до «Механического турка» и големов. Но историю понятий «машинное обучение» и «искусственные нейросети» начинать стоит, пожалуй, с 1940-х годов.

К этому времени мы научились делать довольно сложные устройства, способные работать по заданной программе. Первый универсальный компьютер, ENIAC, собрали в США к концу 1945 года и использовали прежде всего для военных расчётов вроде моделирования термоядерного взрыва — но уже в довоенные годы многие учёные по всему миру испытывали нужду в гибкой вычислительной системе. Создатель первого советского компьютера БЭСМ-1, Сергей Лебедев, например, пришёл в кибернетику из электроэнергетики, где ему не хватило вычислительных инструментов для расчёта устойчивости энергосистем.

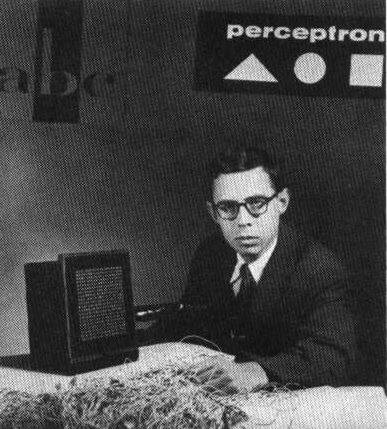

В сочетании с прогрессом в нейрофизиологии — биологи к 1940-м уже знали и о электрических сигналах в живой нервной системе, и о формировании условных рефлексов в системе с хотя бы тремя нервными клетками — потребность в самообучающемся компьютере привела к рождению идеи искусственной нейросети. Поначалу это были устройства, которые пытается имитировать работу настоящей нервной системы — и через это приходили к некоему практическому результату. Например, к распознаванию образов: одна из первых «нейронок», перцептрон Розенблатта, умела различать написанные на контрастном фоне английские буквы.

Розенблатт и его нейрокомпьютер «Марк-1»

В шестидесятые кибернетика переживала настоящий бум машинного обучения. Многим казалось, что вот ещё немного — и вот он, машинный перевод, голосовые интерфейсы, а там и искусственный интеллект с лицом пионера Серёжи Сыроежкина. С самосознанием, эмоциями и сверхчеловеческими способностям. Но этого не случилось: дистанцию от перцептрона до хотя бы сносного машинного зрения в те годы катастрофически недооценили.

В истории дисциплины период разочарования (и, как следствие, сокращение финансирования в этой области) 1970-х годов принято называть «зимой ИИ». Работы Джона Хопфилда и Джеффри Хинтона, опубликованные в 1980-е, стали одними из первых «подснежников», возвестивших наступление весны.

Что такое нейрон

В конце 1950-х годов, когда Розенблатт собрал первое устройство, моделирующее работу нейронной сети. Как именно живые нейроны соединяются друг с другом, обмениваются информацией, а нервная система справляется с совершенно разными задачами — мы до конца не знаем и сегодня. Поэтому напрашивающийся подход «скопировать у природы» на практике не очень-то реализуем. Впрочем, некоторые идеи оказались очень удачными и история нейросетей в XX веке связана с прогрессом в нейронауках.

Самая главная из этих идей — искусственные нейроны. Это не какие-то специальные кремниевые аналоги нервных клеток и даже не программа, детально моделирующая работу нейрона. Искусственная нейросеть является скорее набором правил, которые позволяют взять некоторый набор чисел — входные данные — и скомбинировать его с другим набором чисел. Второй набор можно интерпретировать как информацию о связях между нейронами; эти связи, как и в реальной нейросети, усиливаются или ослабевают после каждой итерации.

В конце 1949 годов, ещё до появления первой искусственной нейросети, канадский нейрофизиолог Дональд Хебб сформулировал правило, описывающее изменения связей между нейронами в живых системах — чтобы клеткам А и Б образовать связь, А должна послать импульсы в направлении Б незадолго до того, как Б отправит сигнал в А.

Итак, ключевые для построения нейросети вопросы:

- как правильно организовать из нейронов сеть;

- по каким правилам должны меняться связи между ними, чтобы она могла учиться.

Нейросети, которые придумал Джон Хопфилд

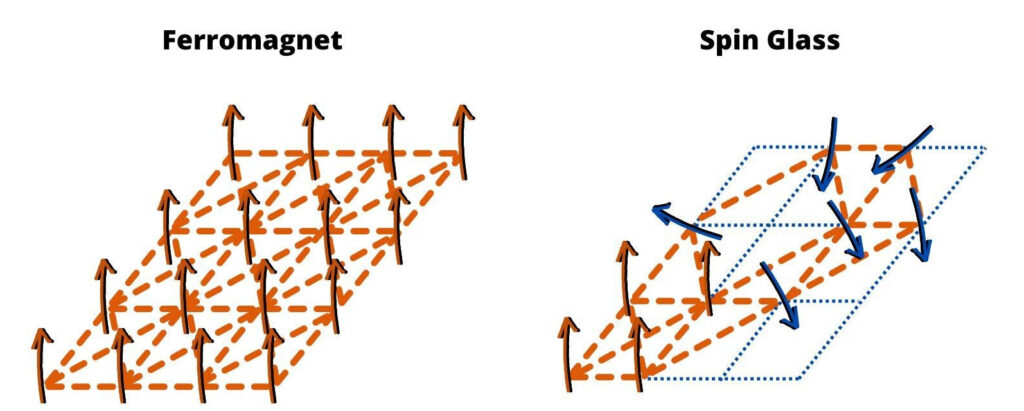

На первый вопрос ответил Хопфилд, предложивший архитектуру сети, которая теперь принесла ему Нобелевскую премию по физике. Сеть Хопфилда была однослойной. Ключевая тут деталь в том, что Хопфилд позаимствовал модель сети не из нейрофизиологии, а из физики твёрдого тела, где уже были придуманы математические модели, описывающие и предсказывающие состояние ансамблей из элементов, которые могут находится в одном из двух возможных состояний. Это были модели спиновых стёкол — которые, кстати, принесли одному из их исследователей, Джорджо Паризи, нобелевскую премию 2021 года.

Системы из магнитных атомов в немагнитном окружении находятся в состоянии «замороженного беспорядка». Это значит, что в ней может быть очень много разных состояний, причём задача поиска наиболее устойчивого состояния из этого множества — невероятно сложная, требующая астрономического объёма вычислений. Поэтому в физике твердого тела моделировали такие системы статистически, в целом, без детального отслеживания отдельных частиц — и Хопфилд применил тот же самый подход для описания своей сети.

Ферромагнитный материал и спиновое стекло.

Рыжие линии — ферромагнитное взаимодействие, синие линии — антиферромагнитное.

То, что это понял именно Хопфилд, не так уж и случайно. Сам он описывает свой кросс-дисциплинарный путь в науке, как череду из поисков и решения необычных исследовательских проблем, которые он может предложить, как физик. После окончания Суортмор-колледжа в Пенсильвании он успел поработать над изучением структуры гемоглобина, в теоретическом отделе Bell Labs (американская телефонная компания; именно там в 1949 создали первый в мире транзистор) и в подразделении «Тихо» NASA, которое собирало информацию о Луне для программы «Аполлон». Именно его перу, кстати, принадлежит термин «поляритон» — взаимодействующие с возбуждениями среды фотоны получили своё название в диссертации Хопфилда. Затем он изучал процессы переноса электронов между молекулами в биологических системах и механизмы коррекции ошибок в биохимических реакциях, а после этого занялся вычислительными системами.

В 1977 году Хопфилд, уже проявив себя на ниве биохимических исследований, получил приглашение на встречу участников международной группы Neuroscience Research Program. Как вспоминает Хопфилд, он ничего не знал о работе мозга, а сама встреча стала для него первым знакомством с тем, что можно, оказывается, всерьез ставить перед собой вопрос о том, как работа мозга производит мышление. И решил, что, пожалуй, сможет наткнуться среди проблем психологов, физиологов и химиков на такую, которой он, как физик, найдет решение.

Он начал свой поиск со знакомства с игрой «Жизнь». Хопфилда интересовало, можно ли заставить клеточный автомат Джона Конвея заниматься вычислениями. Но для этого ему нужно было создать ее симуляцию, чтобы проводить в ней эксперименты. Ученый потратил два года на то, чтобы добиться каких-то успехов в этом направлении, но в итоге пришел к выводу, что его «идея о какой-либо связи между вычислительными механизмами мозга и конвенциональными клеточными автоматами бесполезна». Пришлось смириться и найти задачу попроще — что-то, с чем прекрасно справляется нейробиологическая машинерия, но не характерно для компьютеров. Так Хопфилд пришел, собственно, к теме исследований, за которые теперь получил Нобелевскую премию — модель ассоциативной памяти.

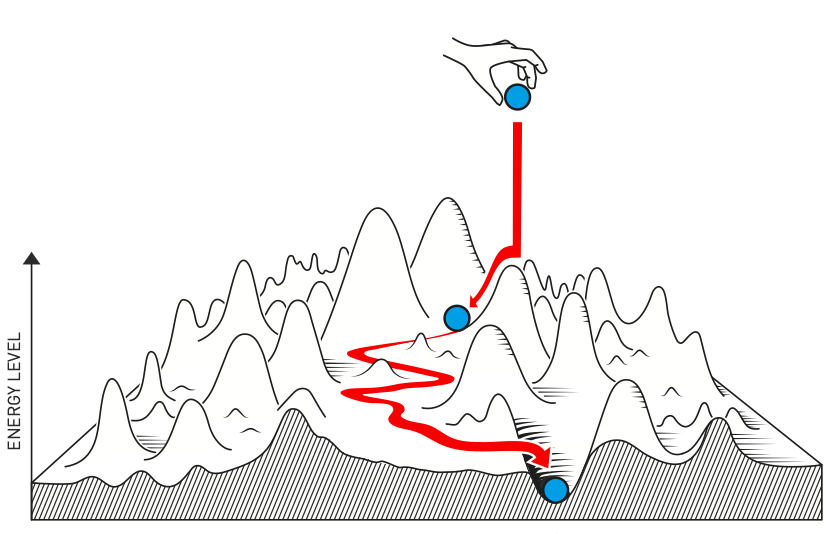

Учёный не просто сумел адаптировать работу физиков Дэвида Шеррингтона и Скотта Киркпатрика с описанием спиновых стёкол. Из той же области, физики магнитных материалов, Хопфилд взял и понятие «энергии системы» — некой величины, которая при достижении устойчивого состояния системы достигает минимально возможного значения.

В сети Хопфилда, в отличие от перцептрона, нет никакого направления передачи сигнала — все ноды в ней связаны со всеми и на каждом шаге эволюции состояния всей сети сверяются с тем, как дела у её ближайших соседей. Общая «энергия» системы всегда остается неизменной, идет лишь внутренняя ее перестройка. Трюк заключается в том, что динамика системы таким образом получает направление: она стремится к своему «минимуму», то есть состоянию, в котором находилась изначально. Поэтому когда ей вход подаются сигналы, она преобразует их так, чтобы «вернуть всё как было», насколько это возможно. Грубо говоря, если вывести на песчаной площадке какой-то узор, а потом полить ее из душа, вода будет скапливаться в бороздках. Так и нейросеть Хопфилда, «запомнившая» какой-то образ, затем прикладывает все усилия к тому, чтобы его воспроизвести.

Когда в обученную сеть («ландшафт») поступают новые сигналы, она «прячет» его туда, где он меньше всего повлияет на ее базовое состояние / NobelPrize

«Сети Хопфилда сильно отличаются от современных, — говорит Дмитрий Ветров, профессор Constructor University (Бремен) и научный руководитель Института искусственного интеллекта и цифровых наук Высшей школы экономики. — Алгоритм вывода в них больше похож на появившийся позднее алгоритм loopy belief propagation для приближенного вывода на марковских сетях, который активно используется сегодня в помехоустойчивом кодировании (точнее, декодировании). Сети Хопфилда продемонстрировали, что нейросеть обладает универсальной способностью запоминать некоторое количество эталонов (бинарных векторов). Причем одна и та же сеть может запоминать разные множества эталонов в зависимости от значений ее весов. Если на вход сети подать произвольный бинарный вектор, активации ее нейронов сойдутся к «ближайшему» из множества эталонов, на которых сеть была обучена. Это не такая глупая задача, как может показаться на первый взгляд. Например, эталонов может быть экспоненциально много (например, всевозможные бинарные строки длины 100) и перебрать их все мы физически не сможем. Или само множество эталонов может быть на этапе применения неизвестно конкретному пользователю. В сущности, это уже очень близко к алгоритмам декодирования помехоустойчивых кодов, без которых была бы невозможна ни современная мобильная связь, ни высокоскоростной интернет».

Гигантские аксоны кальмаров, на которых ставили первые опыты по изучению распространения нервных импульсов, медно-магниевые сплавы (канонический пример спинового стекла) и электронные вычислительные устройства. Три, на первый взгляд, совершенно разных области сошлись вместе на рубеже 1970-х и 1980-х годов в голове Джона Хопфилда и, в первую очередь, позволили исследователям из разных научных дисциплин найти общий — математический — язык.

Обучение и отжиг

Историю другого лауреата — Джеффри Хинтона — можно проследить до его прапрадеда и прапрабабки, британских математиков Джорджа и Мэри Буль. Лежащую в основе всех современных цифровых технологий двоичную логику называют иногда булёвой логикой именно в честь этой супружеской четы — Джордж (1815-1864) разработал правила операций с двоичными переменными, ну а Мэри (1832-1916) внесла немалый вклад в популяризацию как математики в целом, так и наследия супруга в частности. Дочь же вышла замуж за Чарльза Хинтона (1853-1907) — математика, предложившего термин «тессеракт» для четырёхмерного куба.

В 1970 году Хинтон закончил Кембриджский университет, получив диплом — нет, не математика, а психолога. Однако уже через 8 лет он защитил диссертацию, посвящённую уже искусственному интеллекту и уехал на постдок в США, в Калифорнийский университет — где вместе с Дэвидом Румельхартом занялся разработкой метода обратного распространения ошибки. Суть которого в том, что ряд искусственных нейронных сетей с несколькими слоями можно обучить выдавать правильный результат при помощи сигналов, которые проходят через нейроны в обратном порядке — от верхних слоёв к нижним. При этом каждый раз немного меняются веса связей: проще говоря, некоторые связи усиливаются, а некоторые ослабевают.

«Справедливости ради, я бы не преувеличивал это открытие, — замечает Дмитрий Ветров, — так как алгоритм обратного распространения ошибки это просто применение градиентного спуска (хорошо известный метод оптимизации функций) для поиска минимума функции потерь нейронной сети. Применительно к нейронным сетям этот метод независимо переизобретался несколько раз, в том числе и Хинтоном. А вообще, главный вклад в его разработку принадлежит [Готфриду] Лейбницу, впервые получившему правило расчета производной сложной функции (то, что сейчас более известно как chain rule), лежащему не только в основе алгоритма обратного распространения ошибки, но и являющегося основным инструментом для так называемого автоматического дифференцирования, без которого разработка новых нейросетевых архитектур была бы крайне затруднительна».

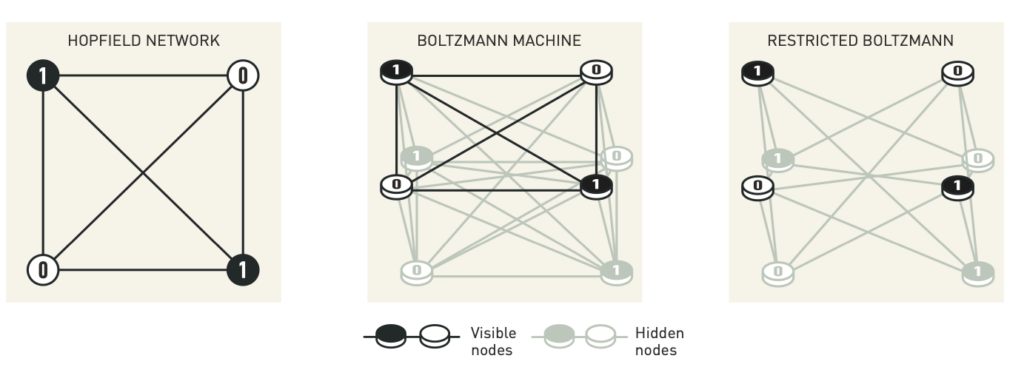

Затем Хинтон описал как скорректировать работу многослойной нейронной сети и от этого перешёл к модели, которая стала известна под именем машины Больцмана. Это уже двухслойная нейронная сеть, в которой — и вот тут мы возвращаемся к работе Хопфилда — связи между “клетками” напоминают связи между элементами спиновых стёкол. Физические аналогии снова сыграли важную роль, так как процесс отжига, нагрева и последующего остывания спинового стекла оказался — в том числе при описании нейросети через аналог энергии — похож на процедуру оптимизации связей между элементами.

Главная особенность сети Хинтона в том, что она состоит из нод двух типов: «скрытых» и «видимых». На выходе мы получаем состояние видимых нод, но пока идет вероятностное преобразование входящих сигналов, в этом процессе участвуют все. Такая система уже не совсем «помнит», но зато умеет обучаться — то есть запоминать конфигурации, которые ей приходится принимать, взаимодействуя с поступающими сигналами.

Сеть Хопфилда, машина Больцмана, ограниченная машина Больцмана

Что еще очень важно — это то, что Хинтон и его сотрудники показали, что больцмановские машины способны к обучению на неразмеченных данных (pre-training) и последующей донастройке на ограниченную размеченную выборку. Сейчас по такой схеме обучают все современные большие языковые модели, к которым как раз относятся столь известные GPT и LLaMA. Количество связей внутри, то есть тех самых «весов», которые корректируются при обучении нейросети, в этих больших моделях превышает десятки миллиардов. Считается, что описание ограниченной машины Больцмана и демонстрация алгоритма ее обучения привлекло внимание ко глубокому обучению, которое используется сегодня повсеместно.

«Больцмановские машины — в первую очередь, конечно, ограниченные больцмановские машины — это вполне живая техника, — говорит Юрий Визильтер, научный руководитель Института искусственного интеллекта МФТИ. — Откройте arXiv.org, забейте поисковый запрос, вы увидите статьи 2024 года. Так что коллеги до сих пор их как-то используют».

Восьмидесятые годы стали не только временем, когда прогресс в области физики твёрдого тела дошёл до описания сложных материалов. Это ещё и то время, когда та же самая физика твёрдого тела позволила создать микропроцессоры, а микропроцессоры на много порядков снизили стоимость вычислений. И вот тут нейросетям стало, наконец, возможно поручить работу поинтереснее, чем просто узнавать написанные на бумаге крупные буквы.

Глава о философских опасениях, или Чего боится Джеффри Хинтон

Хинтон, которому из Стокгольма дозвонились прямо с объявления награды (вручать её будут позже, в декабре), сказал что нейросети, безусловно, усиливают интеллектуальные возможности человека, открывают множество возможностей, увеличивают производительность труда — но одновременно он сам встревожен возможными рисками злоупотребления искусственным интеллектом. А ChatGPT лауреат назвал «полезным, интересным, но ни разу не источником экспертного знания в какой-либо области». Это, на первый взгляд, звучит как совершенно нейтральный и обычный для нынешнего дня ответ на популярный в наше время вопрос. Но в устах Джеффри Хинтона у него на самом деле есть интонация.

«Именно группа Хинтона дала старт революции в машинном обучении в 2012 году, — рассказывает Дмитрий Ветров. — Они представили миру AlexNet — сверточную сеть, огромного по тогдашним меркам размера, обученную с помощью специальных протоколов на большом (опять же, по тогдашним меркам) корпусе изображений. Она продемонстрировала феноменальные (снова, по тогдашним меркам) способности к пониманию изображений и которая дала мощнейший толчок к дальнейшим исследованиям в области глубинного обучения».

У статьи, описывающей архитектуру AlexNet, три автора: Алекс Крижевский, Илья Суцкевер и Хинтон. Последний, как можно догадаться, осуществлял научное руководство над работой молодых аспирантов Университета Торонто. Победу разработанной Крижевским нейросети на международном конкурсе Imagenet нередко называют событием, запустившим продолжающийся сегодня бум в области машинного обучения. Тройку ее создателей моментально нанял Google. В 2015 году Суцкевер перешел в OpenAI, где до недавнего времени разработкой тех самых GPT, о которых теперь знает (и нередко пользуется) каждый школьник. Хинтон оставался в Google до 2023 года. Неизвестно, есть ли прямая связь между уходом Суцкевера из OpenAI, а Хинтона из Google — но озвученные ими причины как минимум рифмуются.

Илья Суцкевер покинул OpenAI после странного эпизода, когда её CEO Сэма Альтмана сначала отстранили от должности, а затем снова восстановили на ней. Журналисты, пытавшиеся разобраться в том, что же такое случилось на верхних этажах компании, предполагали, что это могло быть связано с опасениями Ильи Суцкевера, что они развиваются «слишком быстро».

Джоффри Хинтон покинул Google Brain для того, чтобы сфокусироваться, по его собственному выражению, на «более философской работе» — которая посвящена предотвращению возможных катастроф, связанных с развитием искусственного интеллекта.

76-летний ученый, только что получивший Нобелевскую премию, считает, что рукотворные «умы», к созданию и развитию которых он приложил руку, оказались лучше, чем те, что создала эволюция. И его это пугает. В прошлогоднем интервью для MIT Technology Review Хинтон признался, что до недавнего времени у человеческих мозгов было вполне определенное «магическое» преимущество над искусственными нейросетями, но теперь оно пропало. Примером тому для него стал феномен так называемого few-shot learning — способности больших языковых моделей «доучиваться» буквально на лету, по ходу взаимодействия с оператором.

Уже сейчас, по мнению Хинтона, в мире сосуществуют два типа интеллекта: естественный и искусственный. И что сообщество обладателей естественного интеллекта к этому факту не готово.

Ни в коем случае нельзя утверждать, что Нобелевскую премию по физике в 2024 году дали для того, чтобы поговорить с человечеством об угрозе восстания машин и предупредить нас о неминуемом нашествии роботов. У работ Джона Хопфилда и Джоффри Хинтона есть несомненная научная ценность, и их признание абсолютно заслуженно. Но, возможно, и выкидывать из этого решения убеждения — если угодно, философского характера — одного из лауреатов также не стоит. Хотя бы просто потому, что премию получают люди, с работами которых напрямую связано окончание периода «зимы искусственного интеллекта» 1970-х годов. Причины которой не только в сугубо научно-технических затруднениях исследователей: в сообществе энтузиастов ИИ есть люди, которые связывают ту эпоху с чересчур убедительными — причем не только с логической, но и чисто риторической стороны — аргументами из книги Марвина Минского и Сеймура Паперта «Перцептроны», вышедшей в 1969 году.

А физика ли это?

В 1911 году Нобелевскую премию по физике получил Вильгем Вин, за фундаментальные работы по излучению нагретых тел. Вин отчасти подтолкнул Планка к созданию квантовой модели — так что та премия, безусловно, была по делу. В 1913 году отметили получившего жидкий гелий Хейке Камерлинг-Оннеса, в 1914 году создателя рентгеноструктурного анализа Макса фон Лауэ, а в 1910 году награда досталась крупному специалисту по термодинамике Дидерику Ван дер Ваальсу. 1909-й — Маркони как изобретатель радио, 1918-й — Макс Планк…

Из этого ряда выбивается премия 1912 года Нильсу Далену. Дален получил награду за, цитируем, «изобретение автоматических регуляторов, используемых в сочетании с газоаккумуляторами для источников света на маяках и буях». Это решение до сих пор вызывает недоумение — ладно радио, это применение на практике предсказанных Максвеллом электромагнитных волн, но газовый регулятор?

При всей важности нейронных сетей у многих сегодня возникает схожий вопрос — а физика ли это вообще? Разработка математической модели объекта, которым пристало заниматься скорее физиологам? И реализация модели на вполне обычных компьютерах? Обсуждать политику Нобелевского комитета, конечно, дело бестолковое, однако нелишним будет напомнить о глубинных закономерностях научного познания.

Одна из таких закономерностей — то, что по-настоящему фундаментальное знание можно переносить на самые разные явления и объекты. Примером может служить хотя бы квантовая механика — знания о поведении микроскопических объектов оказались одинаково важны и для корректного описания биологических молекул, и для понимания эволюции Вселенной. Ещё более универсальны математические инструменты, за которые, впрочем нобелевские премии не дают — с векторами или статистическими понятиями вроде «средней величины» работают учёные в любой области, от культурной антропологии до ядерной физики.

Нейронная сеть, вдохновлённая спиновыми стёклами и нейробиологическими системами одновременно — отличный пример универсального инструмента. Мысль, связавшая вместе столь разные закономерности и лёгшая в основу сразу нескольких важных технологий, вполне достойна высшей научной награды.